Aussi dangereuses qu’elles puissent l’être, les Fake News sont pourtant loin de représenter le véritable danger sur Internet. Du point de vu macro-sociétal, elles n’ont pas un impact aussi néfaste que les bulles de filtres (Filter Bubbles). Conceptualisées par Eli Pariser en 2011, les bulles de filtres théorisent l’impact que la sur-personnalisation des contenus par les algorithmes sur les réseaux sociaux peut générer sur l’internaute, l’enfermant dans une sorte de bulle d’isolement intellectuel et informationnel. Mais là encore, la technologie ne peut être seule accusée.

Afin de comprendre les bulles de filtres ainsi que l’impact drastique qu’un réseau social peut engendrer au niveau macro, il nous faut nous faire violence et accepter une dure réalité : les êtres humains sont bien plus influençables et prédictibles que ce que l’on aimerait penser.

Bruno Patino liste certains biais cognitifs qui faussent notre jugement dans La civilisation du poisson rouge : petit traité sur le marché de l’attention. Par exemple les biais de confirmation qui nous poussent à ignorer des informations contredisant nos croyances. C’est un biais qui nous touche tous. Qui n’a jamais fermé les yeux sur une information qui remettait en doute une de ses opinions ? Les biais de représentativité qui mettent en avant un exemple pour aborder une problématique générale et en faire une vérité universelle se nourrissent des moteurs de recherche. Comme l’avance Bruno Patino, ce sont les algorithmes de ces moteurs qui ne travaillent que sur des objets uniques qui renforcent ce biais.

Enfin le biais de simple exposition foisonne sur les réseaux sociaux. La répétition forge dans l’esprit des gens une crédibilité subjective dangereuse. Plus nous voyons une information, plus nous tendons à penser que cette dernière est vraie.

Selon le prix Nobel Daniel Kahneman, il existe plus de 150 biais cognitifs. Certains sont assez évidents comme le biais de conformisme ou l’excès de confiance. D’autres sont plus techniques comme l’effet de Dunning-Kruger (les personnes les moins compétentes surestiment leurs compétences, et les plus compétentes les sous-estiment) ou l’effet de halo qui se produit quand la perception d’une personne ou d’un groupe est influencée par l’opinion que l’on a préalablement pour une de ses caractéristiques. L’effet de notoriété est un exemple classique d’effet de halo.

Big Data, nous voilà :

Non seulement Homo Sapiens est sujet à un grand nombre de biais cognitifs, mais il est également bien plus prédictible qu’il n’y paraît. Dans les années 1980, plusieurs psychologues ont développé un modèle depuis très répandu : le Big Five ou modèle OCEAN pour ouverture, conscienciosité, extraversion, agréabilité et neuroticisme. Ces cinq facteurs permettent une analyse théorique de la personnalité. Avec seulement cinq facteurs il est déjà possible d’avoir une base de recherche afin de se faire une idée sur une personne.

Avec le Big Data, il est possible d’agréger non pas cinq, mais des dizaines de milliers de facteurs avec un nombre phénoménal de données différentes afin d’en tirer avec précision des prédictions très pointues.

Jacques Balmont, cofondateur de l’Agence spatiale française (CNES), explique dans son livre Réseaux ! Le pari de l’intelligence collective que le vrai pouvoir des GAFAM (Google, Amazon, Facebook, Apple et Microsoft), des NATU (Netflix, Airbnb, Tesla, Uber) ou des BATX (Baidu, Alibaba, Tencent et Xiaomi) réside dans leurs algorithmes pouvant passer au crible, découvrir et identifier des structures (pattern) dans les données. L’ancien directeur scientifique du CNES poursuit : A partir de résidus digitaux apparemment inoffensifs, tels que les transactions par cartes de crédit, les pings des tours cellulaires marquant une présence ou l’activité sur le web, ces patterns révèlent un comportement.

Les empreintes numériques avalées, mâchées et recrachées par les algorithmes sont couplées avec des modèles mathématiques complexes permettant de prédire des comportements parfois effrayants. Il est par exemple possible pour Facebook de savoir si vous allez rompre avec votre conjoint-e avant même que vous n’ayez pris la décision. Il est aussi possible pour Facebook de savoir avant vous quand vous allez tomber amoureux. Aux États-Unis, Walmart peut savoir avant une femme si elle est enceinte ou non en analysant les habitudes d’achats de sa carte de fidélité. Amazon a breveté un système permettant de préparer des commandes anticipées avant même qu’elles ne soient effectuées.

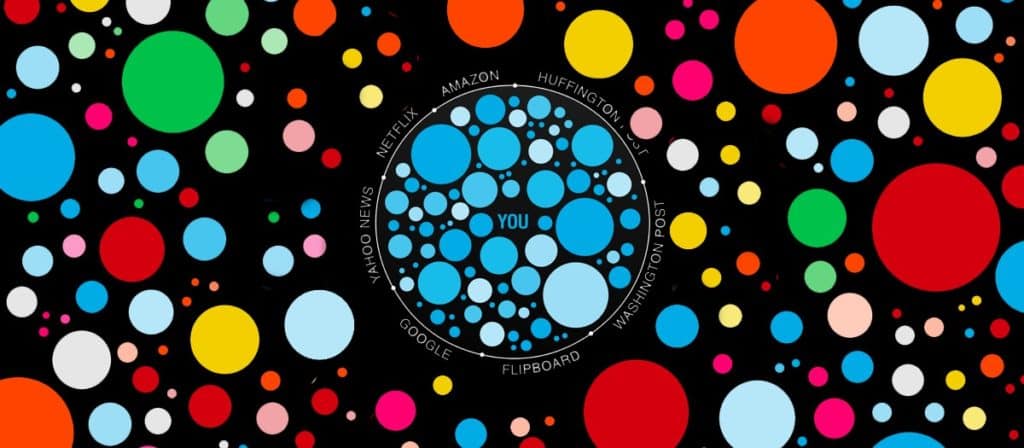

Des moteurs de recherche comme Google prennent en compte plusieurs dizaines de paramètres lorsqu’une recherche est faite : type de browser, quel modèle d’ordinateur, adresse IP, langue par défaut, position géographique, âge et sexe de l’internaute, recherche précédente, suivi de navigation, stockage de mots clés, … afin de personnaliser au maximum la recherche. Plus cette dernière est personnalisée, plus elle risque d’enfermer l’internaute dans une seule et même vision du monde. La bulle de filtre rentre ici en jeu.

Un peu de philosophie :

Dans les articles précédents, nous avons vu que :

- La désinformation et les Fake News se propagent bien plus rapidement et facilement à l’ère d’Internet. Les jeunes générations s’informant principalement sur les réseaux sociaux, l’impact des Fake News est donc plus dangereux et visible aujourd’hui qu’il y a vingt ans.

- Notre rapport aux faits et à la vérité est mis à mal par l’essor de la subjectivité au détriment de l’objectivité, d’un certain déclin de la raison et de l’augmentation des supports d’information permettant une trop grande personnalisation de cette dernière.

La technologie et la sociologie sont intimement liées ici. Les Fake News ne sont que les conséquences les plus visibles de ce cocktail détonnant. L’ingrédient le plus explosif : les bulles de filtres.

C’est du côté de la philosophie cette fois-ci que nous allons trouver les outils nécessaires pour comprendre le problème que cause les bulles de filtres. Et ceci grâce à deux concepts magistralement théorisés par Kant dans la Critique de la raison pure. Kant distingue deux notions fondamentales dans sa philosophie : le noumène et le phénomène. Il explique : l’effet produit par un objet sur la capacité de représentation, dans la mesure où nous sommes affectés par lui, est une sensation. L’intuition qui se rapporte à l’objet à travers une sensation s’appelle empirique. L’objet indéterminé d’une intuition empirique s’appelle phénomène. Nous ne connaissons le monde qu’à travers le prisme de notre structure mentale.

En résumé, les choses telles qu’elles nous apparaissent s’appellent phénomènes. Par opposition, une chose ou un objet tel quel, sans analyse par l’esprit humain, est un noumène.

On pourrait faire un parallèle avec les notions d’Umwelt et d’Umgebund du biologiste allemand Jacob von Uexküll. L’Umwelt est la réalité perçue par une espèce, par extension un groupe, qui peut être drastiquement différente d’une espèce à une autre. Un peu comme les phénomènes de Kant. Le monde est vu au travers de prismes. L’homme ne voit pas les mêmes couleurs qu’un chien, ne ressent pas le soleil avec la même intensité qu’une abeille. Par opposition, l’Umgebund représente la réalité globale infinie. Comme le noumène de Kant, elle évoque la vérité en soi, inatteignable et imperceptible tant que nous sommes esclaves du prisme de notre structure mental, des filtres de notre enveloppe biologique. Tout est question de filtres.

Bulle de filtres

Dans son excellent livre Factfulness, le conférencier et médecin Hans Rosling résume avec brio : Chaque fois que les gens réfléchissent, conjecturent ou s’informent sur le monde, ils s’orientent en fonction de leur vision du monde. Dès lors, si votre vision est fausse, alors vos opinions seront systématiquement fausses.

Les recherches personnalisées agissent justement comme des filtres cloisonnant notre perception du monde dans un seul Umwelt, un seul phénomène en nous faisant croire que l’Umwelt que nous percevons est le seul valable, le seul qui existe. Nous avons ici une bulle de filtres. Plus vous likez des commentaires de droite, et moins vous aurez des contenus de gauche. Moins vous aurez des contenus de gauche et plus vous vous renforcerez dans vos positions de droite. Les éléments extrêmes dans un groupe Facebook poussent la majorité à penser comme eux, faute de contradiction. Les publications jouant sur les émotions sont bien plus virales et se propagent bien plus vite sur Internet. Le débat n’est plus possible, l’opposition d’idées devient un discours de sourds campant sur leurs idéaux renforcés par les bulles de filtres. Le cercle vicieux est bouclé.

La polarisation politique des dernières années n’est donc pas une surprise. Les bulles de filtres ne sont pas étrangères aux tensions autour du Brexit, à l’essor des populismes ou au déficit de l’attention croissant.

En soit la personnalisation n’est pas mauvaise, au contraire. La standardisation est dangereuse et bon nombre de dystopies jouent là-dessus, de 1984 d’Orwell à La Servante écarlate d’Atwood en passant par Le Meilleur des mondes d’Huxley. La personnalisation permet de promouvoir la diversité et de stimuler le perfectionnement de soi, d’optimiser notre temps et d’augmenter notre plaisir de surfer sur Internet. Mais tout dépend du but sous-jacent de cette personnalisation. Dans le cas d’internet, elle est quasi uniquement utilisée pour des raisons économiques. En renforçant le taux de clic d’un contenu, en augmentant le temps que nous passons sur un fil d’actualité ainsi que le potentiel d’interaction avec une publicité, les gros acteurs du numérique augmentent leurs revenus publicitaires.

Si le seul objectif de la personnalisation des recherches et des contenus est d’augmenter l’ARPU (average revenu per user) des GAFA, la personnalisation risque en effet de créer des bulles de filtres et de nous enfermer dans des tiroirs à clichés. Le problème c’est qu’après avoir été enfermé dans ce tiroir avec l’étiquette « jeune caucasien de droite ayant un niveau d’étude rudimentaire », un internaute ne verra que plus rarement des contenus divergents de ses opinions. La remise en question, substance vitale de la démocratie, passe au second plan. La sérendipité, soit le fait de découvrir de manière inopinée de nouvelles passions par exemple, perd du terrain également.

Les bulles de filtres ont permis à un concept médiatique bien connu, les chambres d’écho, de se multiplier. Dans une chambre d’écho, les opinions opposées à celles de la majorité sont peu diffusées et, lorsqu’elles le sont, sont souvent la cible d’attaques discriminatoires de la part de cette même majorité. Certains journaux et médias n’ont pas attendus l’avènement des réseaux sociaux pour jouer le rôle de chambre d’écho. Le concept a été popularisé à la fin des années 1990. Mais désormais, les chambres d’écho médiatiques sont propulsées et démultipliées à cause des bulles de filtres que les algorithmes créent par raison économique.

Dès lors, il est donc possible de se demander comment ces algorithmes fonctionnent ? Et à quel degré ils remettent en question notre libre arbitre. Ce sera le sujet du prochain billet.